名校

1 . 在信息论中,熵(entropy)是接收的每条消息中包含的信息的平均量,又被称为信息熵、信源熵、平均自信息量.这里,“消息”代表来自分布或数据流中的事件、样本或特征.(熵最好理解为不确定性的量度而不是确定性的量度,因为越随机的信源的熵越大)来自信源的另一个特征是样本的概率分布.这里的想法是,比较不可能发生的事情,当它发生了,会提供更多的信息.由于一些其他的原因,把信息(熵)定义为概率分布的对数的相反数是有道理的.事件的概率分布和每个事件的信息量构成了一个随机变量,这个随机变量的均值(即期望)就是这个分布产生的信息量的平均值(即熵).熵的单位通常为比特,但也用 、

、 、

、 计量,取决于定义用到对数的底.采用概率分布的对数作为信息的量度的原因是其可加性.例如,投掷一次硬币提供了1

计量,取决于定义用到对数的底.采用概率分布的对数作为信息的量度的原因是其可加性.例如,投掷一次硬币提供了1 的信息,而掷

的信息,而掷 次就为

次就为 位.更一般地,你需要用

位.更一般地,你需要用 位来表示一个可以取

位来表示一个可以取 个值的变量.在1948年,克劳德•艾尔伍德•香农将热力学的熵,引入到信息论,因此它又被称为香农滳.而正是信息熵的发现,使得1871年由英国物理学家詹姆斯•麦克斯韦为了说明违反热力学第二定律的可能性而设想的麦克斯韦妖理论被推翻.设随机变量

个值的变量.在1948年,克劳德•艾尔伍德•香农将热力学的熵,引入到信息论,因此它又被称为香农滳.而正是信息熵的发现,使得1871年由英国物理学家詹姆斯•麦克斯韦为了说明违反热力学第二定律的可能性而设想的麦克斯韦妖理论被推翻.设随机变量 所有取值为

所有取值为 ,定义

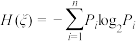

,定义 的信息熵

的信息熵 ,(

,( ,

, ).

).

(1)若 ,试探索

,试探索 的信息熵关于

的信息熵关于 的解析式,并求其最大值;

的解析式,并求其最大值;

(2)若 ,

, (

( ),求此时的信息熵.

),求此时的信息熵.

、

、 、

、 计量,取决于定义用到对数的底.采用概率分布的对数作为信息的量度的原因是其可加性.例如,投掷一次硬币提供了1

计量,取决于定义用到对数的底.采用概率分布的对数作为信息的量度的原因是其可加性.例如,投掷一次硬币提供了1 的信息,而掷

的信息,而掷 次就为

次就为 位.更一般地,你需要用

位.更一般地,你需要用 位来表示一个可以取

位来表示一个可以取 个值的变量.在1948年,克劳德•艾尔伍德•香农将热力学的熵,引入到信息论,因此它又被称为香农滳.而正是信息熵的发现,使得1871年由英国物理学家詹姆斯•麦克斯韦为了说明违反热力学第二定律的可能性而设想的麦克斯韦妖理论被推翻.设随机变量

个值的变量.在1948年,克劳德•艾尔伍德•香农将热力学的熵,引入到信息论,因此它又被称为香农滳.而正是信息熵的发现,使得1871年由英国物理学家詹姆斯•麦克斯韦为了说明违反热力学第二定律的可能性而设想的麦克斯韦妖理论被推翻.设随机变量 所有取值为

所有取值为 ,定义

,定义 的信息熵

的信息熵 ,(

,( ,

, ).

).(1)若

,试探索

,试探索 的信息熵关于

的信息熵关于 的解析式,并求其最大值;

的解析式,并求其最大值;(2)若

,

, (

( ),求此时的信息熵.

),求此时的信息熵.

您最近半年使用:0次

2024-01-16更新

|

1523次组卷

|

7卷引用:河北省2024届高三上学期大数据应用调研联合测评数学试题

河北省2024届高三上学期大数据应用调研联合测评数学试题河北省石家庄市十八中2024届高三上学期1月联考数学试题(已下线)考点15 数列中的数学文化 2024届高考数学考点总动员【练】广东省中山市中山纪念中学2024届高三上学期第三次模拟测试数学试题(已下线)压轴题概率与统计新定义题(九省联考第19题模式)练(已下线)微考点8-1 新高考新题型19题新定义题型精选(已下线)专题22 新高考新题型第19题新定义压轴解答题归纳(9大核心考点)(讲义)

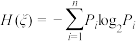

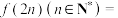

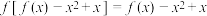

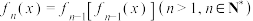

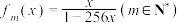

2 . 已知函数 满足:

满足: ,

, ,

, 成立,且

成立,且 ,则

,则 ( )

( )

满足:

满足: ,

, ,

, 成立,且

成立,且 ,则

,则 ( )

( )A. | B. | C. | D. |

您最近半年使用:0次

2023-12-28更新

|

1217次组卷

|

6卷引用:河北省保定市部分重点高中2024届高三上学期12月期末数学试题

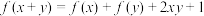

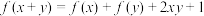

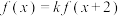

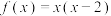

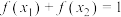

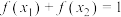

3 . 已知定义域为 的函数

的函数 满足

满足 .

.

(1)若 ,求

,求 ;又若

;又若 ,求

,求 .

.

(2)设有且仅有一个实数 ,使得

,使得 ,求函数

,求函数 的解析式.

的解析式.

的函数

的函数 满足

满足 .

.(1)若

,求

,求 ;又若

;又若 ,求

,求 .

.(2)设有且仅有一个实数

,使得

,使得 ,求函数

,求函数 的解析式.

的解析式.

您最近半年使用:0次

2020-10-01更新

|

820次组卷

|

5卷引用:河北省廊坊第十二中学2022-2023学年高一上学期期末数学试题

解题方法

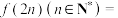

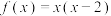

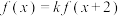

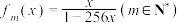

4 . 已知函数 对任意实数

对任意实数 均有

均有 ,其中常数

,其中常数 为负数,且

为负数,且 在区间

在区间 上有表达式

上有表达式 .

.

(1)写出 在

在 上的表达式,并写出函数

上的表达式,并写出函数 在

在 上的单调区间(不用过程,直接写出即可);

上的单调区间(不用过程,直接写出即可);

(2)求出 在

在 上的最小值与最大值,并求出相应的自变量的取值.

上的最小值与最大值,并求出相应的自变量的取值.

对任意实数

对任意实数 均有

均有 ,其中常数

,其中常数 为负数,且

为负数,且 在区间

在区间 上有表达式

上有表达式 .

.(1)写出

在

在 上的表达式,并写出函数

上的表达式,并写出函数 在

在 上的单调区间(不用过程,直接写出即可);

上的单调区间(不用过程,直接写出即可);(2)求出

在

在 上的最小值与最大值,并求出相应的自变量的取值.

上的最小值与最大值,并求出相应的自变量的取值.

您最近半年使用:0次

名校

5 . 设 是定义在

是定义在 上的函数,它的图象关于点

上的函数,它的图象关于点 对称,当

对称,当 时,

时, (

( 为自然对数的底数),则

为自然对数的底数),则 的值为

的值为

是定义在

是定义在 上的函数,它的图象关于点

上的函数,它的图象关于点 对称,当

对称,当 时,

时, (

( 为自然对数的底数),则

为自然对数的底数),则 的值为

的值为A. | B. | C. | D. |

您最近半年使用:0次

2017-08-29更新

|

422次组卷

|

2卷引用:河北省正定中学2016-2017学年高二下学期第四次月考(期末)数学(理)试题

6 . 已知 ,设

,设 ,

, ,若

,若 ,则

,则 ( )

( )

,设

,设 ,

, ,若

,若 ,则

,则 ( )

( )A. | B. | C. | D. |

您最近半年使用:0次

2017-08-12更新

|

70次组卷

|

2卷引用:河北省邢台市2016-2017学年高二下学期期末考试数学(理)试题

解题方法

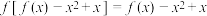

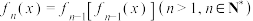

7 . 设 ,函数

,函数 满足

满足 ,若

,若 ,则

,则 的最小值为

的最小值为

,函数

,函数 满足

满足 ,若

,若 ,则

,则 的最小值为

的最小值为A. | B. | C. | D. |

您最近半年使用:0次

2016-12-03更新

|

1497次组卷

|

3卷引用:河北省唐山市路北区2024届高三上学期期末模拟数学试题