名校

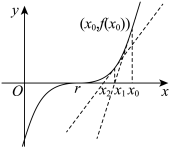

1 . 牛顿迭代法是牛顿在17世纪提出的一种在实数域和复数域上近似求解方程的方法.比如,我们可以先猜想某个方程 的其中一个根r在

的其中一个根r在 的附近,如图6所示,然后在点

的附近,如图6所示,然后在点 处作

处作 的切线,切线与x轴交点的横坐标就是

的切线,切线与x轴交点的横坐标就是 ,用

,用 代替

代替 重复上面的过程得到

重复上面的过程得到 ;一直继续下去,得到

;一直继续下去,得到 ,

, ,

, ,…,

,…, .从图形上我们可以看到

.从图形上我们可以看到 较

较 接近r,

接近r, 较

较 接近r,等等.显然,它们会越来越逼近r.于是,求r近似解的过程转化为求

接近r,等等.显然,它们会越来越逼近r.于是,求r近似解的过程转化为求 ,若设精度为

,若设精度为 ,则把首次满足

,则把首次满足 的

的 称为r的近似解.

称为r的近似解.

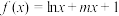

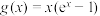

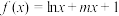

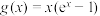

已知函数 ,

, .

. 满足精度

满足精度 的近似解(取

的近似解(取 ,且结果保留小数点后第二位);

,且结果保留小数点后第二位);

(2)若 对任意

对任意 都成立,求整数a的最大值.(计算参考数值:

都成立,求整数a的最大值.(计算参考数值: ,

, ,

, ,

, ,

, )

)

的其中一个根r在

的其中一个根r在 的附近,如图6所示,然后在点

的附近,如图6所示,然后在点 处作

处作 的切线,切线与x轴交点的横坐标就是

的切线,切线与x轴交点的横坐标就是 ,用

,用 代替

代替 重复上面的过程得到

重复上面的过程得到 ;一直继续下去,得到

;一直继续下去,得到 ,

, ,

, ,…,

,…, .从图形上我们可以看到

.从图形上我们可以看到 较

较 接近r,

接近r, 较

较 接近r,等等.显然,它们会越来越逼近r.于是,求r近似解的过程转化为求

接近r,等等.显然,它们会越来越逼近r.于是,求r近似解的过程转化为求 ,若设精度为

,若设精度为 ,则把首次满足

,则把首次满足 的

的 称为r的近似解.

称为r的近似解.已知函数

,

, .

.

满足精度

满足精度 的近似解(取

的近似解(取 ,且结果保留小数点后第二位);

,且结果保留小数点后第二位);(2)若

对任意

对任意 都成立,求整数a的最大值.(计算参考数值:

都成立,求整数a的最大值.(计算参考数值: ,

, ,

, ,

, ,

, )

)

您最近一年使用:0次

2024-04-02更新

|

690次组卷

|

8卷引用:【一题多变】零点估计 牛顿切线

(已下线)【一题多变】零点估计 牛顿切线云南三校2024届高三高考备考实用性联考卷(六)数学试题浙江省舟山市舟山中学2023-2024学年高二下学期4月清明返校测试数学试题(已下线)模块3 第8套 复盘卷(已下线)模块五 专题4 全真能力模拟4(苏教版高二期中研习)(已下线)第二章导数及其应用章末综合检测卷(新题型)-【帮课堂】2023-2024学年高二数学同步学与练(北师大版2019选择性必修第二册)宁夏银川一中、云南省昆明一中2024届高三下学期5月联合考试二模理科数学试卷广东省深圳市福田区红岭中学2024届高三高考适应性考试数学试卷

名校

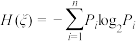

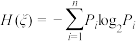

2 . 在信息论中,熵(entropy)是接收的每条消息中包含的信息的平均量,又被称为信息熵、信源熵、平均自信息量.这里,“消息”代表来自分布或数据流中的事件、样本或特征.(熵最好理解为不确定性的量度而不是确定性的量度,因为越随机的信源的熵越大)来自信源的另一个特征是样本的概率分布.这里的想法是,比较不可能发生的事情,当它发生了,会提供更多的信息.由于一些其他的原因,把信息(熵)定义为概率分布的对数的相反数是有道理的.事件的概率分布和每个事件的信息量构成了一个随机变量,这个随机变量的均值(即期望)就是这个分布产生的信息量的平均值(即熵).熵的单位通常为比特,但也用 、

、 、

、 计量,取决于定义用到对数的底.采用概率分布的对数作为信息的量度的原因是其可加性.例如,投掷一次硬币提供了1

计量,取决于定义用到对数的底.采用概率分布的对数作为信息的量度的原因是其可加性.例如,投掷一次硬币提供了1 的信息,而掷

的信息,而掷 次就为

次就为 位.更一般地,你需要用

位.更一般地,你需要用 位来表示一个可以取

位来表示一个可以取 个值的变量.在1948年,克劳德•艾尔伍德•香农将热力学的熵,引入到信息论,因此它又被称为香农滳.而正是信息熵的发现,使得1871年由英国物理学家詹姆斯•麦克斯韦为了说明违反热力学第二定律的可能性而设想的麦克斯韦妖理论被推翻.设随机变量

个值的变量.在1948年,克劳德•艾尔伍德•香农将热力学的熵,引入到信息论,因此它又被称为香农滳.而正是信息熵的发现,使得1871年由英国物理学家詹姆斯•麦克斯韦为了说明违反热力学第二定律的可能性而设想的麦克斯韦妖理论被推翻.设随机变量 所有取值为

所有取值为 ,定义

,定义 的信息熵

的信息熵 ,(

,( ,

, ).

).

(1)若 ,试探索

,试探索 的信息熵关于

的信息熵关于 的解析式,并求其最大值;

的解析式,并求其最大值;

(2)若 ,

, (

( ),求此时的信息熵.

),求此时的信息熵.

、

、 、

、 计量,取决于定义用到对数的底.采用概率分布的对数作为信息的量度的原因是其可加性.例如,投掷一次硬币提供了1

计量,取决于定义用到对数的底.采用概率分布的对数作为信息的量度的原因是其可加性.例如,投掷一次硬币提供了1 的信息,而掷

的信息,而掷 次就为

次就为 位.更一般地,你需要用

位.更一般地,你需要用 位来表示一个可以取

位来表示一个可以取 个值的变量.在1948年,克劳德•艾尔伍德•香农将热力学的熵,引入到信息论,因此它又被称为香农滳.而正是信息熵的发现,使得1871年由英国物理学家詹姆斯•麦克斯韦为了说明违反热力学第二定律的可能性而设想的麦克斯韦妖理论被推翻.设随机变量

个值的变量.在1948年,克劳德•艾尔伍德•香农将热力学的熵,引入到信息论,因此它又被称为香农滳.而正是信息熵的发现,使得1871年由英国物理学家詹姆斯•麦克斯韦为了说明违反热力学第二定律的可能性而设想的麦克斯韦妖理论被推翻.设随机变量 所有取值为

所有取值为 ,定义

,定义 的信息熵

的信息熵 ,(

,( ,

, ).

).(1)若

,试探索

,试探索 的信息熵关于

的信息熵关于 的解析式,并求其最大值;

的解析式,并求其最大值;(2)若

,

, (

( ),求此时的信息熵.

),求此时的信息熵.

您最近一年使用:0次

2024-01-16更新

|

1832次组卷

|

8卷引用:考点15 数列中的数学文化 2024届高考数学考点总动员【练】

(已下线)考点15 数列中的数学文化 2024届高考数学考点总动员【练】(已下线)压轴题概率与统计新定义题(九省联考第19题模式)练(已下线)微考点8-1 新高考新题型19题新定义题型精选(已下线)专题22 新高考新题型第19题新定义压轴解答题归纳(9大核心考点)(讲义)河北省2024届高三上学期大数据应用调研联合测评数学试题河北省石家庄市十八中2024届高三上学期1月联考数学试题河北省衡水市武邑中学2023-2024学年高二下学期第二次月考数学试题广东省中山市中山纪念中学2024届高三上学期第三次模拟测试数学试题

2024·全国·模拟预测

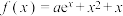

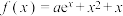

3 . 已知函数 .

.

(1)若曲线 在

在 处的切线方程为

处的切线方程为 ,求

,求 ,

, 的值;

的值;

(2)若函数 ,且

,且 恰有2个不同的零点,求实数

恰有2个不同的零点,求实数 的取值范围.

的取值范围.

.

.(1)若曲线

在

在 处的切线方程为

处的切线方程为 ,求

,求 ,

, 的值;

的值;(2)若函数

,且

,且 恰有2个不同的零点,求实数

恰有2个不同的零点,求实数 的取值范围.

的取值范围.

您最近一年使用:0次

2024-01-05更新

|

1218次组卷

|

8卷引用:第4讲:利用导数研究函数的零点问题【讲】 高三清北学霸150分晋级必备

(已下线)第4讲:利用导数研究函数的零点问题【讲】 高三清北学霸150分晋级必备(已下线)广东省清远市2023-2024学年高二下学期期中联合考试数学试题变式题16-19(已下线)2024年普通高等学校招生全国统一考试数学文科预测卷(一)(已下线)2024年普通高等学校招生全国统一考试数学理科预测卷(七)(已下线)高三理科数学开学摸底考(全国甲卷、乙卷通用)(已下线)第五章 一元函数的导数及其应用(单元测试)-2023-2024学年高二数学同步精品课堂(人教A版2019选择性必修第二册)四川省成都市简阳实验学校2024届高三下学期开学考试数学(理)试题福建省泉州市安溪蓝溪中学2023-2024学年高二下学期3月月考数学试题

名校

解题方法

4 . 已知函数 ,

, .

.

(1)若 的最大值是0,求

的最大值是0,求 的值;

的值;

(2)若对任意 ,

, 恒成立,求

恒成立,求 的取值范围.

的取值范围.

,

, .

.(1)若

的最大值是0,求

的最大值是0,求 的值;

的值;(2)若对任意

,

, 恒成立,求

恒成立,求 的取值范围.

的取值范围.

您最近一年使用:0次

2024-01-27更新

|

725次组卷

|

13卷引用:模块三 大招11 隐零点代换

(已下线)模块三 大招11 隐零点代换(已下线)专题07 函数与导数常考压轴解答题(练习)河北省部分学校2024届高三上学期12月大联考考后强化卷数学试题(新课标I卷)山东省德州市第一中学2024届高三上学期1月月考数学试题四川省绵阳市南山中学实验学校2024届高三上学期1月月考数学(理)试题(已下线)第09讲 第五章 一元函数的导数及其应用 重点题型章末总结-【帮课堂】2023-2024学年高二数学同步学与练(人教A版2019选择性必修第二册)(已下线)第五章 一元函数的导数及其应用(知识归纳+题型突破)-2023-2024学年高二数学单元速记·巧练(人教A版2019选择性必修第二册)四川省泸州市合江县马街中学校2024届高三下学期开学考试数学(理)试题四川省泸州市合江县马街中学校2024届高三下学期开学考试数学(文)试题山东省滕州市2024届高三上学期期中考试数学试题湖南省长沙市湖南师大附中2024届高三上学期月考(四)数学试题江西省宜春市百树学校2024届高三上学期期中数学试题内蒙古鄂尔多斯市西四旗2024届高三上学期期末综合模拟数学(文)试题

名校

解题方法

5 . 已知函数 ,

, .

.

(1)求函数 的极值;

的极值;

(2)若 ,求函数

,求函数 的最小值;

的最小值;

(3)若 有两个零点

有两个零点 ,

, ,证明:

,证明: .

.

,

, .

.(1)求函数

的极值;

的极值;(2)若

,求函数

,求函数 的最小值;

的最小值;(3)若

有两个零点

有两个零点 ,

, ,证明:

,证明: .

.

您最近一年使用:0次

2023-11-26更新

|

1647次组卷

|

7卷引用:专题2-6 导数大题证明不等式归类-2

(已下线)专题2-6 导数大题证明不等式归类-2(已下线)专题07 函数与导数常考压轴解答题(12大核心考点)(讲义)(已下线)黄金卷05(已下线)第10讲 第五章 一元函数的导数及其应用 章节验收测评卷(综合卷)-【帮课堂】2023-2024学年高二数学同步学与练(人教A版2019选择性必修第二册)陕西省汉中市普通高中联盟学校2023-2024学年高三上学期期中联考数学(理)试题陕西省咸阳市武功县普集高级中学2024届高三上学期第4次月考数学(理)试题(已下线)特训03 一元函数的导数及其应用 压轴题(七大母题型归纳)-2023-2024学年高二数学《重难点题型·高分突破》(人教A版2019选择性必修第二册)

名校

6 . 已知函数 .

.

(1)当 时,求曲线

时,求曲线 在点

在点 处的切线方程;

处的切线方程;

(2)当 时,若关于x的不等式

时,若关于x的不等式 恒成立,求实数a的取值范围.

恒成立,求实数a的取值范围.

.

.(1)当

时,求曲线

时,求曲线 在点

在点 处的切线方程;

处的切线方程;(2)当

时,若关于x的不等式

时,若关于x的不等式 恒成立,求实数a的取值范围.

恒成立,求实数a的取值范围.

您最近一年使用:0次

2023-11-20更新

|

573次组卷

|

6卷引用:专题04 导数及其应用(4大易错点分析+解题模板+举一反三+易错题通关)

(已下线)专题04 导数及其应用(4大易错点分析+解题模板+举一反三+易错题通关)辽宁省部分学校2023-2024学年高三上学期11月期中考试数学试题湖北省部分高中联考协作体2023-2024学年高三上学期期中考试数学试卷湖南省衡阳市衡南县2023-2024学年高三上学期11月期中联考数学试题福建省部分校2024届高三上学期期中考试数学试题辽宁省抚顺市六校协作体2024届高三上学期期中数学试题

名校

7 . 已知函数 .

.

(1)讨论函数 的极值点个数;

的极值点个数;

(2)若 ,

, 的最小值是

的最小值是 ,求实数

,求实数 的取值范围.

的取值范围.

.

.(1)讨论函数

的极值点个数;

的极值点个数;(2)若

,

, 的最小值是

的最小值是 ,求实数

,求实数 的取值范围.

的取值范围.

您最近一年使用:0次

2023-10-28更新

|

921次组卷

|

8卷引用:第03讲 极值与最值(七大题型)(讲义)

(已下线)第03讲 极值与最值(七大题型)(讲义)(已下线)重难点06 导数必考压轴解答题全归类【十一大题型】(已下线)专题3.2 函数的单调性、极值与最值【七大题型】(已下线)6.2.2 导数与函数的极值、最值(2知识点+6题型+强化训练)-【帮课堂】2023-2024学年高二数学同步学与练(人教B版2019选择性必修第三册)四川省宜宾市2023届高三三模数学(理科)试题山东省济宁市第一中学2022-2023学年高二下学期期中考试数学试题山西省山西大学附属中学与东北师大附中2024届高三上学期期中联考数学试题吉林省长春市东北师范大学附属中学2023-2024学年高三上学期第二次模拟考试数学试题

名校

8 . 已知函数 在区间

在区间 上的最小值为

上的最小值为 ,则实数a的取值范围为( )

,则实数a的取值范围为( )

在区间

在区间 上的最小值为

上的最小值为 ,则实数a的取值范围为( )

,则实数a的取值范围为( )A. | B. | C. | D. |

您最近一年使用:0次

2023-10-11更新

|

823次组卷

|

8卷引用:热点2-5 导数的应用-单调性与极值(8题型+满分技巧+限时检测)

(已下线)热点2-5 导数的应用-单调性与极值(8题型+满分技巧+限时检测)(已下线)专题09 函数与导数(解密讲义)(已下线)第03讲 函数的单调性、极值和最值-【寒假预科讲义】2024年高二数学寒假精品课(人教A版2019)(已下线)6.2.2 导数与函数的极值、最值(2知识点+6题型+强化训练)-【帮课堂】2023-2024学年高二数学同步学与练(人教B版2019选择性必修第三册)单元测试B卷——第五章 一元函数的导数及其应用山东省潍坊市2023-2024学年高三上学期10月月考数学试题河北承德双滦区实验中学2024届高三上学期九月月考数学模拟试题山东省潍坊安丘市三区县2023-2024学年高三上学期10月过程性检测数学试题

9 . 在直角坐标系 中,点

中,点 到

到 轴的距离等于点

轴的距离等于点 到点

到点 的距离,记动点

的距离,记动点 的轨迹为

的轨迹为 .

.

(1)求 的方程;

的方程;

(2)已知矩形 有三个顶点在

有三个顶点在 上,证明:矩形

上,证明:矩形 的周长大于

的周长大于 .

.

中,点

中,点 到

到 轴的距离等于点

轴的距离等于点 到点

到点 的距离,记动点

的距离,记动点 的轨迹为

的轨迹为 .

.(1)求

的方程;

的方程;(2)已知矩形

有三个顶点在

有三个顶点在 上,证明:矩形

上,证明:矩形 的周长大于

的周长大于 .

.

您最近一年使用:0次

2023-06-08更新

|

38629次组卷

|

23卷引用:第07讲 抛物线及其性质(练习)

(已下线)第07讲 抛物线及其性质(练习)(已下线)第08讲 直线与圆锥曲线的位置关系(练习)(已下线)专题15 圆锥曲线综合(已下线)导数及其应用(已下线)第2讲:各类对称问题的应用【练】(已下线)第6讲:最值范围问题【练】(已下线)专题07 双曲线与抛物线(讲义)(已下线)第2讲:不等式的解法与性质、基本不等式【练】(已下线)专题08 圆锥曲线 第三讲 圆锥曲线中的最值与范围问题(解密讲义)(已下线)专题18 圆锥曲线高频压轴解答题(16大核心考点)(讲义)-1(已下线)专题24 解析几何解答题(文科)-1(已下线)专题04 高考解几大题真题精练(已下线)专题24 解析几何解答题(理科)-3(已下线)专题5 考前押题大猜想21-25(已下线)2023年高考数学真题完全解读(新高考Ⅰ卷)专题07平面解析几何(成品)专题07平面解析几何(添加试题分类成品)专题07平面解析几何(成品)(已下线)2023年新课标全国Ⅰ卷数学真题变式题19-22(已下线)模块一 情境6 以解析几何为背景上海市实验学校2023-2024学年高二下学期期中考试数学试题2023年新课标全国Ⅰ卷数学真题第三章 圆锥曲线的方程 (单元测)

名校

解题方法

10 . 已知抛物线 :

: 与圆

与圆 :

: 相交于

相交于 四个点.

四个点.

(1)当 时,求四边形

时,求四边形 面积;

面积;

(2)当四边形 的面积最大时,求圆

的面积最大时,求圆 的半径

的半径 的值.

的值.

:

: 与圆

与圆 :

: 相交于

相交于 四个点.

四个点.

(1)当

时,求四边形

时,求四边形 面积;

面积;(2)当四边形

的面积最大时,求圆

的面积最大时,求圆 的半径

的半径 的值.

的值.

您最近一年使用:0次